除了场景生成之外,世界模型还在驾驶情境下的学习、评估潜在的未来情景以及改进规划和控制策略方面发挥着重要作用。例如,Model-based Imitation Learning (MILE) 采用基于模型的模仿学习方法,在CARLA环境中从离线数据集中联合学习动力学模型和驾驶行为。MILE运用一种“广义推理算法”来进行合理且可视化的未来驾驶环境想象和预测,利用想象来补偿缺失的感知信息。这一能力使得规划未来的行动成为可能,从而使自动驾驶汽车能够在没有高精度地图的情况下运行。在CARLA模拟器内的不熟悉测试场景中,MILE的表现显著优于最先进的模型,将驾驶评分从46提高到了61(相比专家数据评分为88)。MILE的特点在于长时间跨度和高度多样化的未来预测。通过对预测的未来状态使用解码器,MILE展示了在各种情景下稳定的驾驶表现。

SEM2在RSSM的基础上引入了语义掩模世界模型,以增强端到端自动驾驶的采样效率和鲁棒性。作者认为世界模型的隐状态包含太多与任务无关的信息,这会负面影响采样效率和系统鲁棒性。此外,由于训练数据不平衡,世界模型难以处理意外情况。为了应对这些问题,引入了一个特征筛选器来提取关键的任务特征,并使用这些筛选后的特征重建语义掩模。针对数据不平衡问题,使用了一个采样器来平衡数据分布。在每个训练批次中,来自不同场景的样本被均匀添加,从而实现训练样本的均衡和平衡分布,这对泛化能力和解决极端案例是有利的。经过在CARLA中的训练和测试后,SEM2的性能相较于DreamerV2有了显著提升。

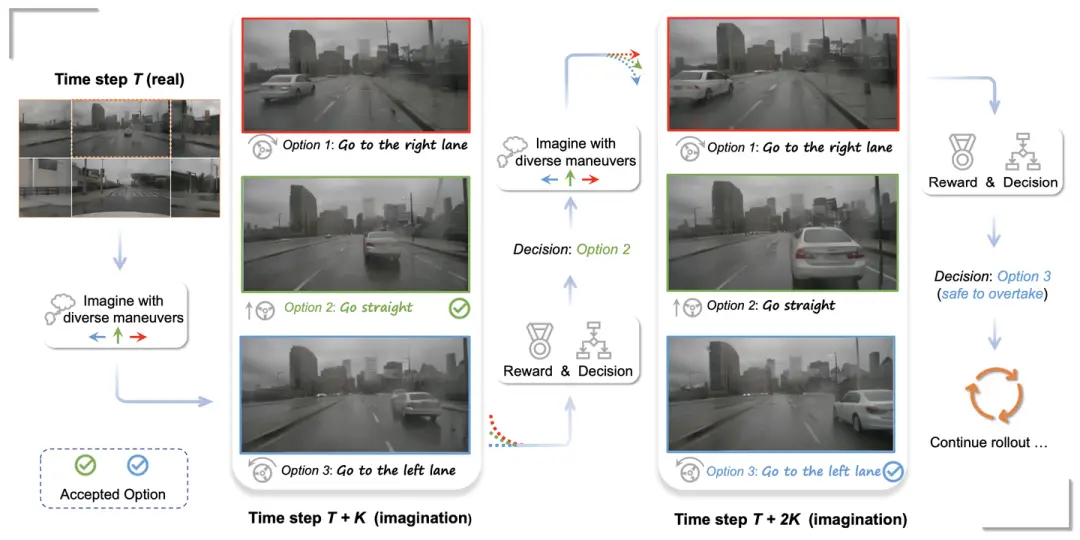

多视图建模:考虑到大多数自动驾驶车辆通常配备多个摄像头,多视图建模也是世界模型中的一个关键方面。Drive-WM是第一个专为增强端到端自动驾驶规划安全性而设计的多视图世界模型。通过多视图和时序建模,Drive-WM联合生成多个视角的画面,并从相邻画面预测中间视角,显著提高了多视图间的一致性。此外,Drive-WM引入了一个简单的统一条件接口,可以灵活地应用图像、动作、文本等条件,简化了条件生成的过程。在具有六个视角的nuScenes数据集上进行训练和验证,Drive-WM通过采样预测的候选轨迹并使用基于图像的奖励函数来选择最佳路径。此外,与GAIA-1相似,Drive-WM在非行驶区域导航的能力展示了世界模型对于理解及处理领域外案例的潜力。

另外,受到Alberto Elfes开创性工作的启发 ,UniWorld 引入了一种创新方法,即利用多帧点云融合作为生成4D占用标签的真实数据。这种方法考虑了来自多摄像头系统的图像中存在的时空关联。通过利用未标记的图像-激光雷达对UniWorld进行了世界模型的预训练,显著增强了对环境动态的理解。在nuScenes数据集上测试时,与依赖单目预训练的方法相比,UniWorld在运动预测和语义场景补全等任务的IoU(交并比)上显示出显著改进。

参考:

World Models for Autonomous Driving: An Initial Survey

ADriver-I: A General World Model for Autonomous Driving

来源:汽车未来科技Lab