2024亚马逊云科技re:Invent大幕开启。

伴随熟悉的音乐,亚马逊云科技高级副总裁Peter DeSantis登台,带来每年拉开re:Invent大幕的传统环节《周一晚间秀》。

开场环节,Peter首先用“树根”这个比喻,阐述了亚马逊云科技创新的源动力。一棵参天大树,枝叶繁茂的背后,是深深扎进土壤的根系。Peter提到,亚马逊云科技的成功同样源自对细节的执着追求,得益于公司自身的文化基因,亚马逊云科技在扩展规模的同时,坚定地关注安全性、运营效率、成本和创新,为客户带来独一无二的云计算服务与客户体验。

持续引领云计算基础设施创新

在接下来的分享中,Peter首先邀请亚马逊云科技计算与网络副总裁David Brown登台,回顾亚马逊云科技通过投入芯片创新,在云计算运营性能、安全、成本等方面积累的独特能力。

一、Graviton系列芯片:如今50%亚马逊云科技的新增CPU容量,都运行在Graviton之上。

亚马逊云科技于2018年推出第一代Graviton系列CPU芯片,提供了与x86相当的性能,Graviton2则在广泛的工作负载类型中提供优于x86的性能表现,Graviton3则为Nginx等工作负载提供了高达60%的性能提升。Graviton4代表了迄今最强大的Graviton芯片,相比Graviton3具有3倍的vCPU数量,适用于需求苛刻的企业工作负载。

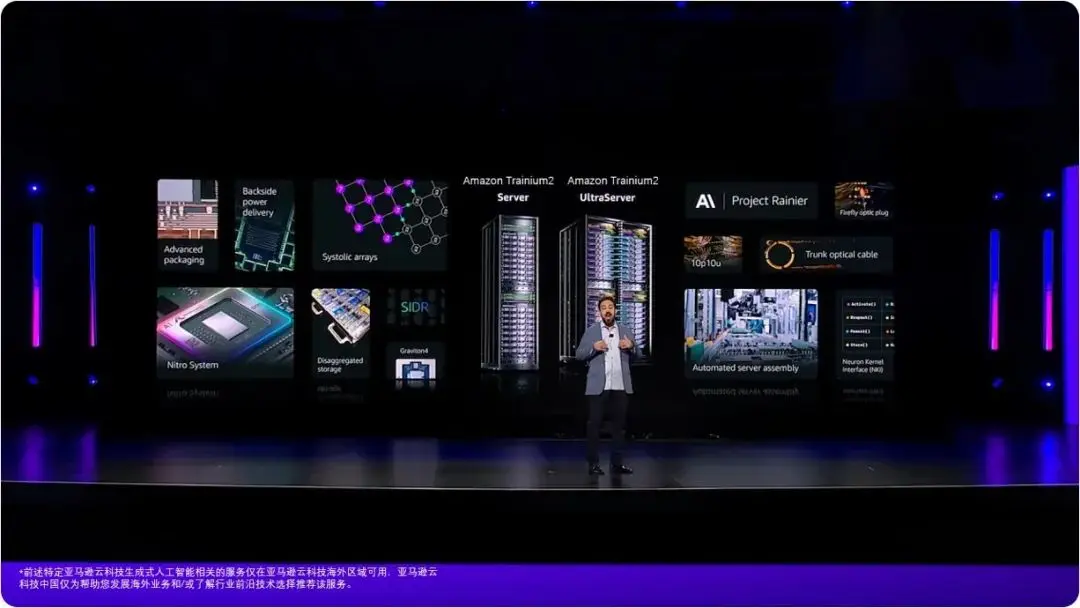

二、Nitro系统:革新亚马逊云科技的服务器架构,引入硬件完整性的验证管控机制。

Nitro系统通过将大部分虚拟化功能卸载到专用硬件芯片上,极大简化了虚拟机监控程序,消除了传统虚拟化的性能开销。为了确保整个硬件供应链的安全性,从芯片制造阶段开始,Nitro就对每个硬件组件进行加密认证,为了从根本上防止硬件层面的攻击和篡改。

Nitro芯片与Graviton处理器配合,可创建一个相互锁定的信任网络,使CPU到CPU、CPU到Nitro芯片的所有连接都由硬件提供安全保护。

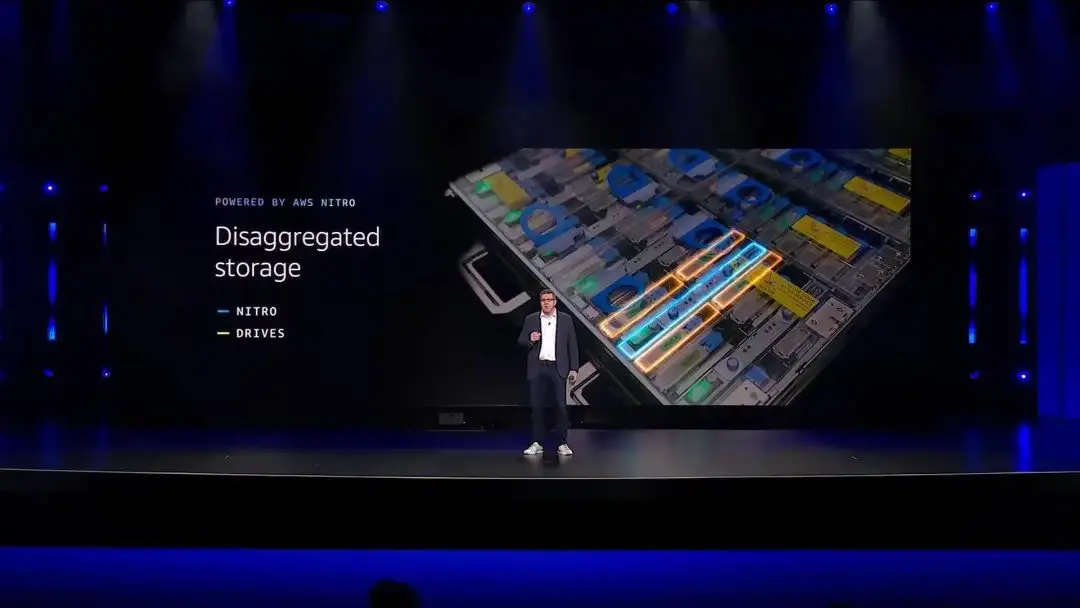

另外,存储驱动器嵌入Nitro卡,将每个驱动器视为一个安全的独立的网络存储节点,从而实现存储和计算的分离。

这种存储分离架构使计算和存储资源可独立扩展,极大减少故障影响范围,加快恢复速度,并适应不断增长的扩容需求,从而最终提高了存储服务的敏捷性、可靠性和效率。

开启人工智能基础设施新篇章

接下来,Peter将重点聚焦在构建人工智能基础设施的创新上。首先,Peter援引了一篇2020年发布的论文:人工智能中巨量的计算负载,并不能完全通过横向扩展(Scale out)资源来解决,也同样需要纵向扩展单个计算单元的能力(Scale up)。

Peter提出了构建人工智能基础设施的两个基本支柱:首先,构建更强大的服务器;第二,构建更大规模、更高效率的服务器集群。

Trainium2芯片及Trainium2服务器

接下来,Peter介绍了Trainium2芯片及基于其构建的Trainium加速器及服务器。

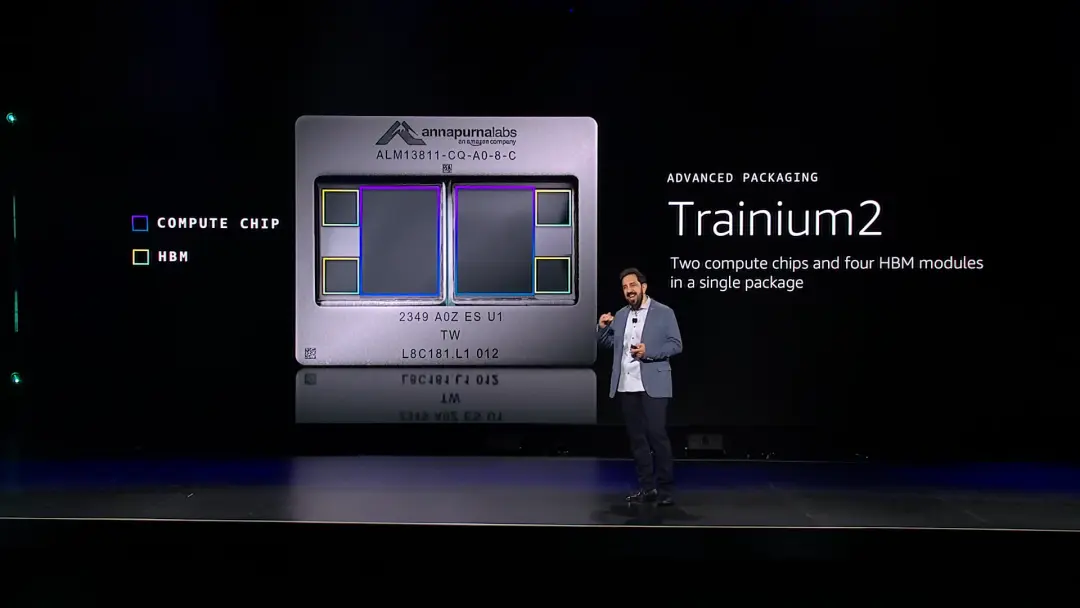

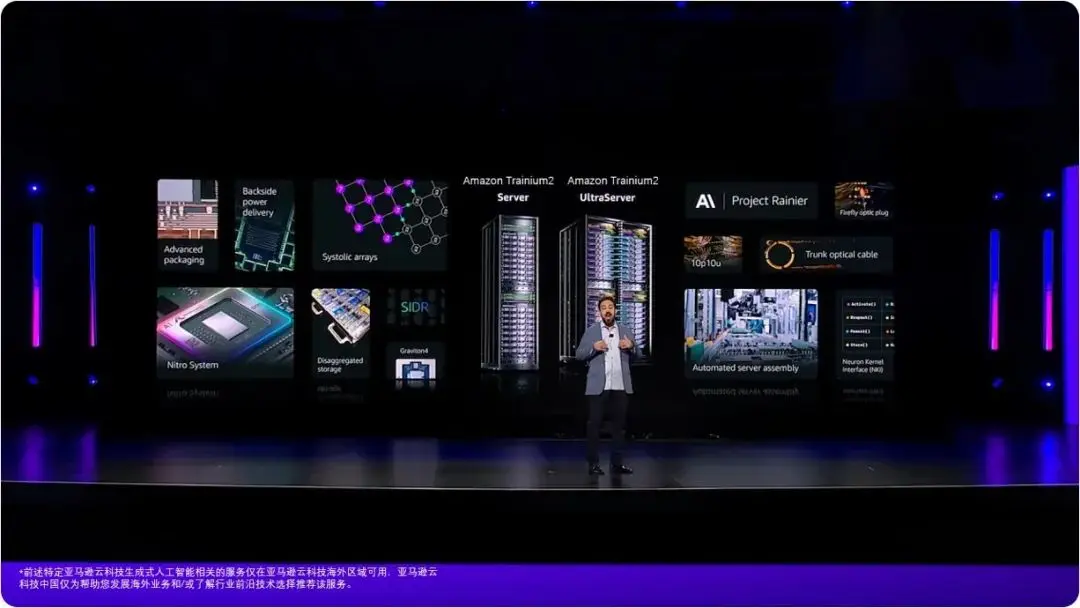

Trainium2专门为人工智能工作负载而设计,采用了先进的封装技术,将计算芯片和高带宽内存(HBM)模块集成在一个紧凑的封装(package)内。每个Trainium2加速器(单卡)内封装中有两个Trainium2计算核心,而每个核心旁边都配备了两块HBM内存模块,从而实现了计算和内存的无缝集成。这种先进的封装设计克服了芯片尺寸的工程极限,最大限度地缩小了计算和内存之间的距离,使用大量高带宽、低延迟的互连将它们连接在一起。这不仅降低了延迟,还能使用更高效的协议交换数据,提高了性能。

此外,Trainium2还将电压调节器移至封装周围,靠近芯片本身,通过更短的导线为芯片供电,减少了电压下降,提高了能效。

基于Trainium2加速器,亚马逊云科技推出了全新的Trainium2服务器(Trainium2 Server),每台Trainium服务器搭载16块Trainium加速器,并配备有专用的Nitro加速卡和机头。一台Trainium服务器可提供20万亿次每秒浮点运算能力,是亚马逊云科技当前最大AI服务器的1.25倍。同时,它还拥有1.5TB的高速HBM内存,是现有最大AI服务器的2.5倍,显存带宽达46TB/s。

Trainium2 UltraServer

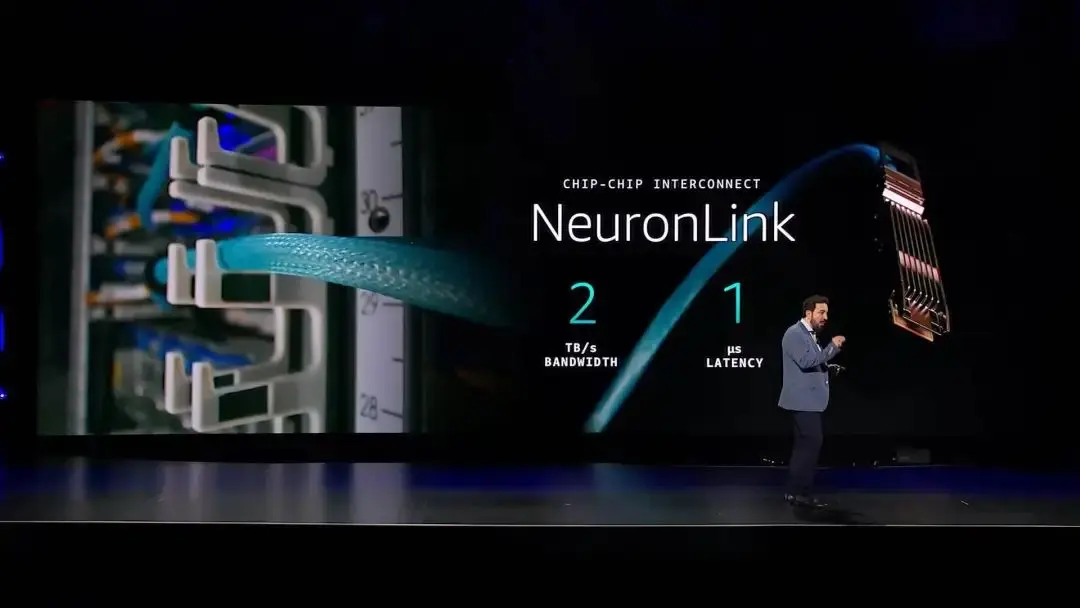

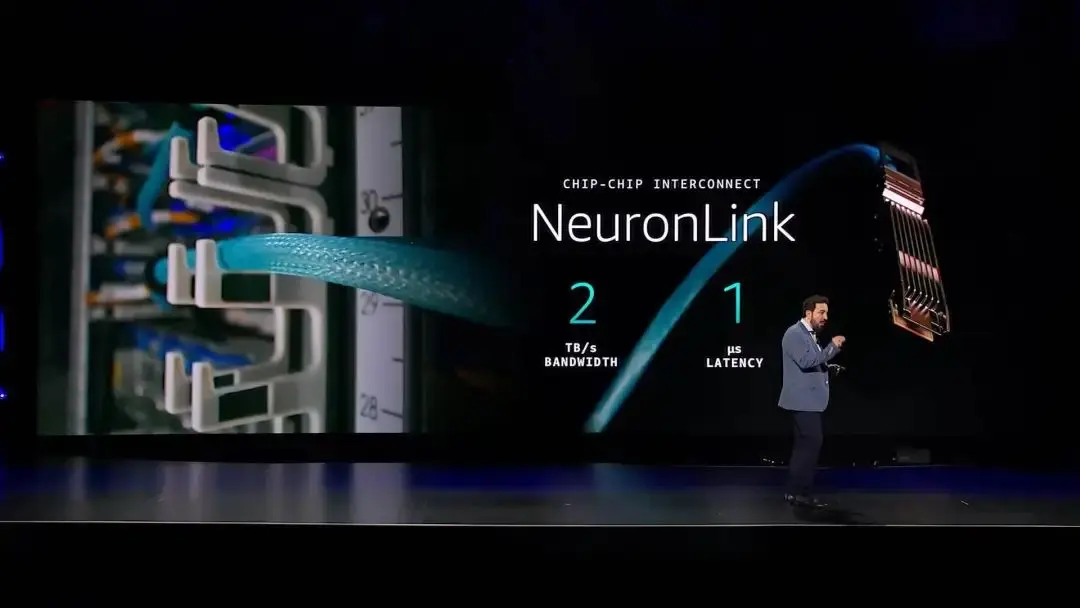

而在推动前沿模型的发展的进程中,对于极为苛刻的人工智能工作负载来说,再强大的计算能力也永远不够。为了提供更加极致的计算能力,Peter介绍了全新发布的Neuronlink技术。Neuronlink是亚马逊云科技专有的网络互连技术,它能够将多台Trainium服务器组合成一个逻辑上的单一服务器,连接带宽可达2TB/s的带宽,而延迟仅为1微秒。

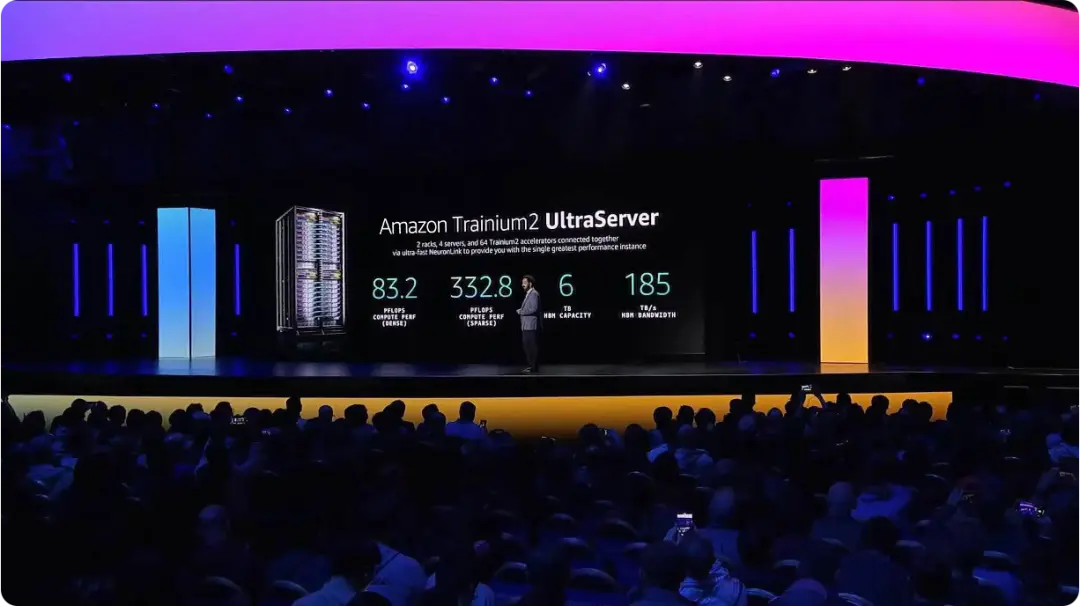

通过Neuronlink,芯片之间可以直接访问彼此的内存,就像是一台超级计算机一样工作。这种由Neuronlink技术集成的多服务器集群,被称为 “UltraServer”。Peter展示并发布了由64个Trainum2加速器构成的Trainium2 UltraServer,可提供83.2万亿次每秒浮点运算能力,6TB HBM高速内存,及185 TB/s的HBM内存带宽。相比亚马逊云科技现有人工智能训练实例,UltraServer的计算能力高出5倍,内存容量则是现有规模最大者的10倍。“这正是训练万亿级参数的大型人工智能模型所需要的超级计算平台,非常强大” Peter介绍到。

Amazon Bedrock低延迟优化推理发布

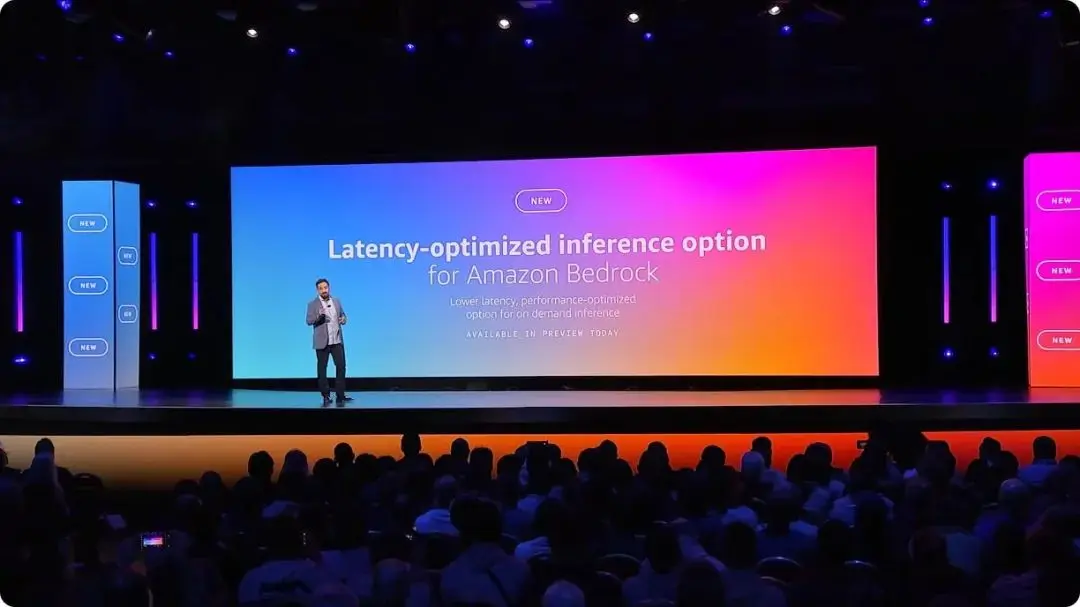

基于强大的Tranium2服务器,亚马逊云科技推出了Amazon Bedrock低延迟优化推理。

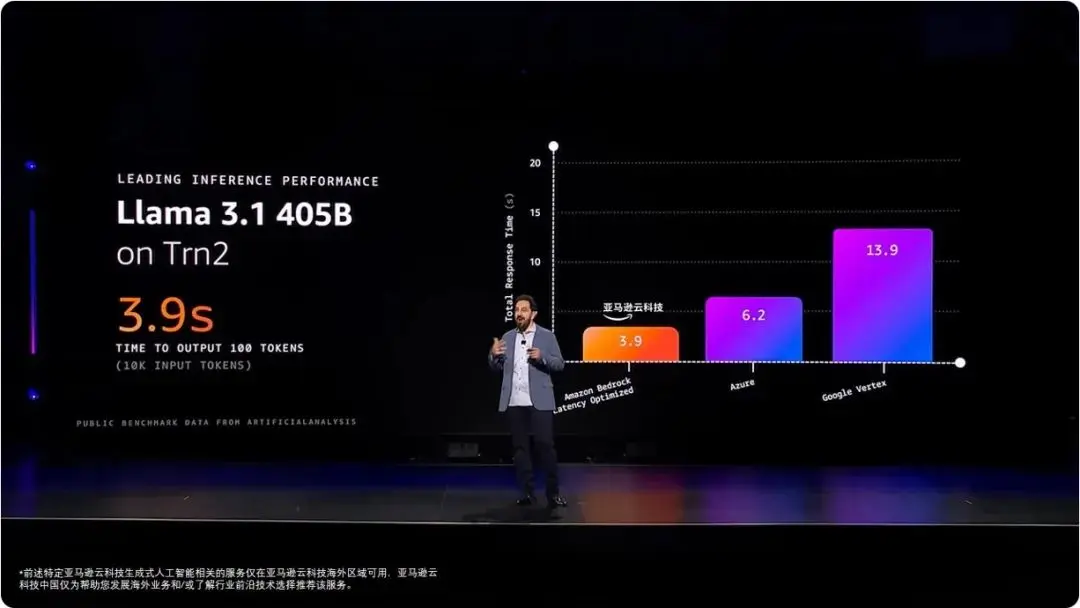

这一创新功能让客户能够访问亚马逊云科技最新的人工智能基础设施和软件优化技术,在各种领先模型上获得卓越的推理性能。其中,广受欢迎的Llama模型的Llama 405B和Llama 70B低延迟优化版本,在亚马逊云科技上展现出超越其他云提供商的出色表现。

同时,亚马逊云科技与Anthropic合作,推出了人工智能模型Claude 3.5的低延迟优化版本,为客户提供更优秀的体验,通过低延迟模式运行Claude Haiku,将提速60%。

本场最大的亮点:Anthropic联合创始人兼首席计算官Tom Brown宣布下一代Claude模型将在Project Rainier上训练,这是一个集成数十万个Trn2芯片的集群,运算能力是以往集群的5倍多,加速Claude模型迭代。客户可以用更低价格、更快速度使用更高智能的模型。

构建强大的人工智能集群网络

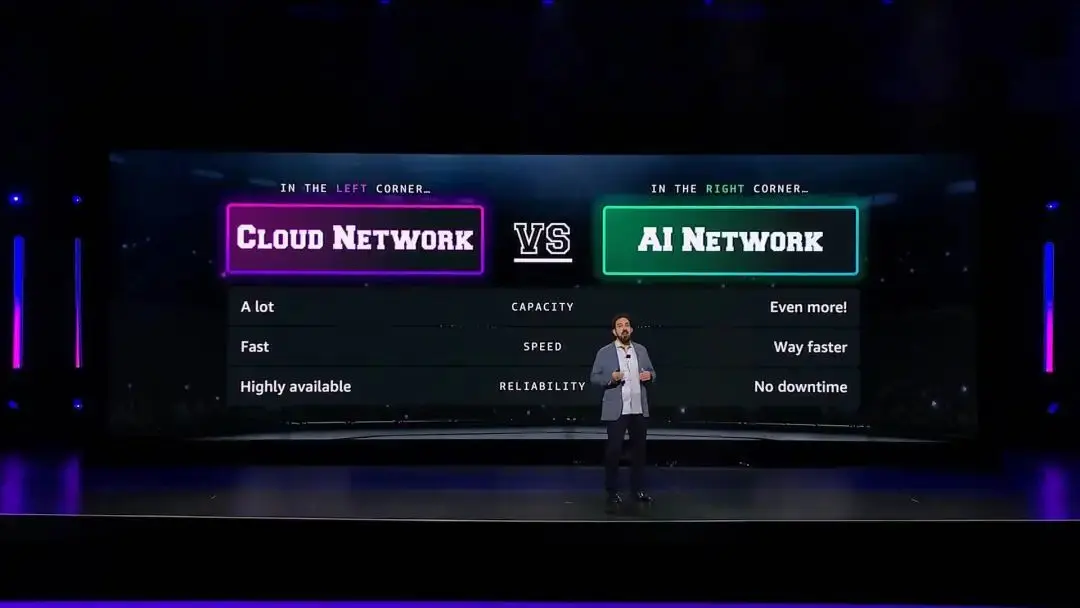

在构建大规模人工智能集群方面,Peter指出,网络是关键。人工智能对网络提出了更高的要求:更大的网络带宽,更快速的获取网络资源,更高的可靠性。

亚马逊云科技开发出面向大规模人工智能集群的网络架构“10p10u网络”。这是一种为超大规模服务器集群提供连接的网络架构,被用于驱动基于UltraSever或Nvidia节点构建的大规模计算集群,为数以千计的计算节点之间提供数十PB/s的网络带宽,延迟低于10微秒。“10p10u网络”具有大规模并行和高密度互连的特点,可以从少量机架扩展到跨越多个数据中心的大规模集群,具有良好的弹性。

最后,Peter总结:通过持续在诸如Nitro、Graviton和存储等领域的核心创新投资,亚马逊云科技正在构建更强大的人工智能服务器。而持续的领先,来自于对硬件细节极致的追求。

来源:亚马逊云科技