Ⅱ 背景

A. 任务

目标检测是计算机视觉中的一个核心挑战,涉及在图像中定位预定义类别的目标,回归其边界框,确定其类别,并且在自动驾驶的背景下,估计其速度以提高驾驶安全性。目标检测可以统一为以下范例[11]

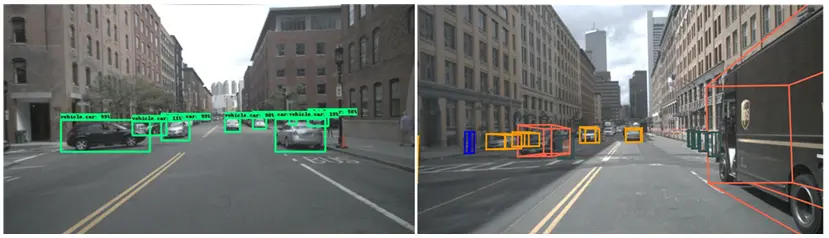

其中,是场景中 个对象的集合,是一个对象检测模型,是一个或多个传感输入。当前的道路上物体检测任务可以分为两种型:二维物体检测和三维物体检测。这两种任务的物体表示 是不同的,这决定了后续预测和规划步骤可用的信息。在大多数情况下,二维物体和三维物体的表示分别为输入图像中的矩形包围框和三维坐标系中的长方体,分别记为和,表示为

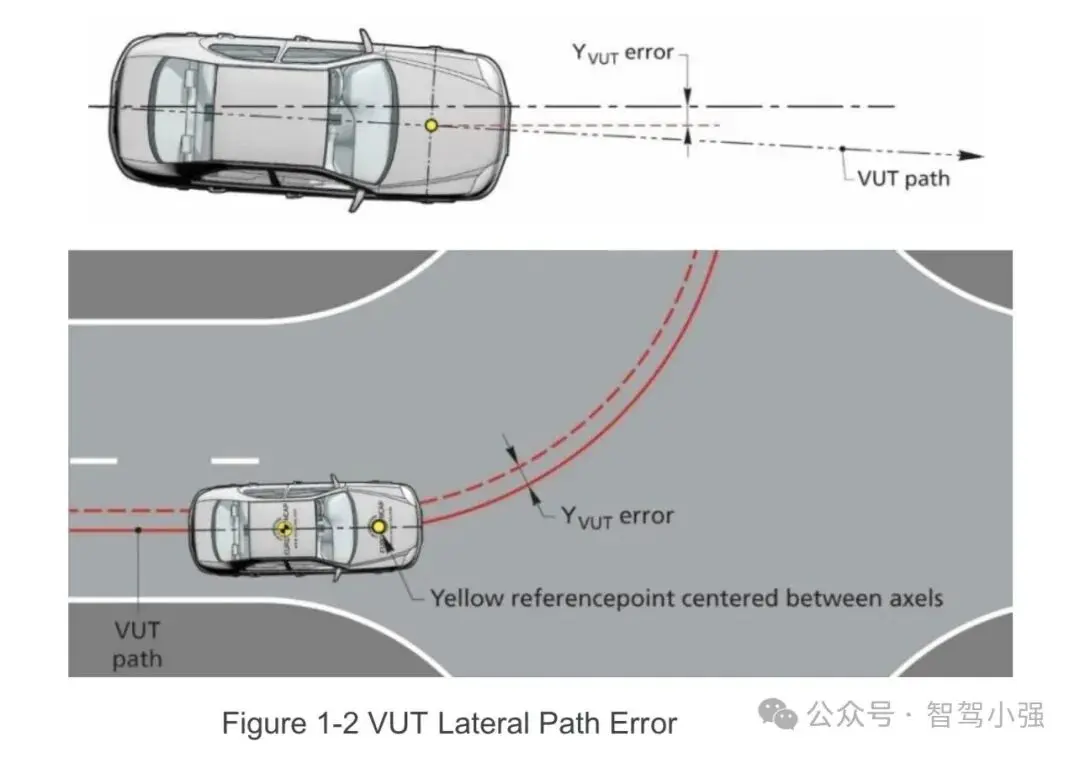

图 2. 二维和三维物体检测结果。左:二维物体检测[13]。右:三维物体检测[14]

其中,、和、分别是矩形包围框的二维中心 坐标和形状参数,、、 和 、、分别是立方体的三维中心坐标和形状参数,是立方体的 航向角,class 表示物体的类别。在某些特定场景中,特别是在道路物体检测中,物体的沿地面平面的速度分量、也被视为补充参数。

B. 数据集

该数据集是深度学习基于对象检测的研究基础。表二总结了一些广泛使用的公共数据集,这些数据集包括摄像头和雷达设置,用于自动驾驶场景。此外,它还包括了最新的数据集,这些数据集包含了4D雷达点云。表 中的“雷达”指的是传统的毫米波雷达,与包括高度信息的“4D雷达”不同。nuScenes[12]数据集是nuTonomy 建立的用于自动驾驶的最常用且传感器丰富的数据集之 一。用于收集该数据集的车辆配备了六个环绕摄像头、 五个环绕雷达和一个覆盖360度视野的激光雷达。它为道路场景中的23类3D边界框提供了注释。除了nuScenes 数据集外,所有其他数据集的摄像头都只能向前看。RadarScene[17]数据集有大量标注的帧,但缺乏激光雷达数据。Astyx[7]数据集是第一个使用新一代4D雷达的数据集。不幸的是,它只有数量有限的标注帧,并且其 类别分布不均衡,这使得它不适合大多数基于数据驱动的深度学习目标检测研究。VoD [18] 数据集和 TJ4DRadSet [19] 数据集是两个新颖的自动驾驶数据集,其特点是复杂的城市道路场景,包含众多同步和校准的摄像头、激光雷达和 4D 雷达数据的帧。K-Radar [41] 是最新的大规模目标检测数据集,包含 35K 帧的 4D 雷达张量数据。然而,仍然缺乏类似于 nuScenes 的多模态数据集,为每种类型的传感器覆盖 360°的环绕视图,这对于基于 RV 融合的环绕感知研究至关重要。此外,由于数据驱动的大型模型技术的发展,大规模且场景丰富的 数据集仍然有需求。

C. 其他

评估指标和输入数据格式在[10]中进行了详细的讨论,本文不再赘述。值得注意的是,在[10]的第三部分 B 节中,给出了雷达点云的一般形式, 其中传统毫米波雷达提供的高度信息不准确,但4D雷达可以提供精确的值。

Ⅲ 基于雷达视觉融合的三维物体检测

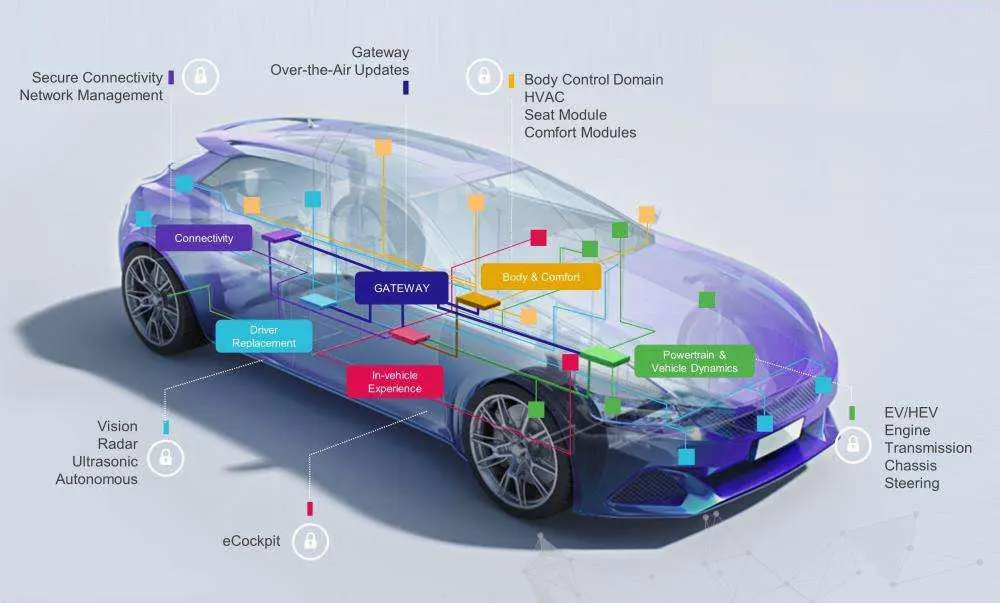

融合来自不同传感器的数据可以充分利用它们各自感知优势,从而在物体检测方面比依赖单一类型的传感器具有更强的性能。本节全面概述了基于深度学习的3D 物体检测方法,以及用于自动驾驶汽车的RV融合框架。 融合方法包括两种类型:感兴趣区域(ROI)和端到端融合。从可靠性的角度来看,在某种类型的传感器出现故障时,基于ROI的融合策略可以完全依赖于其他类型传感器的提议来检测物体。然而,在大多数情况下,端到端融合策略可以更全面地整合来自两种传感器数据的特征。

A. 基于投资回报率的融合

基于 ROI 的融合最初使用一种类型传感器的输入信息来生成初步的感兴趣区域(ROI)。随后,从另一种传感器的数据或融合的多模态数据中进一步提取与这些 ROI 相对应的特征,以进行分类和细化。由于 3D 到 2D 变换的简单性,它只需要一个变换矩阵,无需额外的信 息,大多数基于 ROI 的融合都采用从雷达点云中提取 ROI 的工作流程,然后将它们投影到图像上进行特征提取。这种方法,如[26]-[29]中引用的工作所示,被称为雷达生成的 ROI,如图 3(a)所示。另一种策略是先检测图像上的对象,然后基于边界框裁剪图像块,最后使用雷达点补充速度和其他信息,如[30]、[31]中所做的,称为视觉生成的 ROI,如图 3(b)所示。

来源:同济智能汽车研究所