一、项目背景

智能网联汽车向高阶自动驾驶迭代,多模态传感器(如多摄像头、毫米波雷达、激光雷达)已成为环境感知系统的核心配置。硬件在环(HIL,Hardware In the Loop)仿真作为关键验证手段,需支持多传感器物理级建模,以应对复杂场景下感知算法训练、控制策略验证的严苛需求,但传统仿真技术难以满足多传感器协同仿真的效率和精度要求。

现有HIL平台在多传感器仿真中面临算力、带宽、扩展性三重瓶颈:高精度传感器模型(如4K视频流渲染、多线雷达模拟)导致算力资源紧张;PCIe总线带宽限制与接口数量不足(如单机显卡接口≤4个)引发数据同步延迟和通道数量受限,迫使车企延长30%以上验证周期,严重拖累自动驾驶研发进程。

二、多传感器注入HIL仿真系统

基于深信科创OASIS SIM构建的多传感器注入HIL仿真系统,以虚实融合架构为核心,打通从高精度场景仿真到传感器信号闭环验证的全链路。

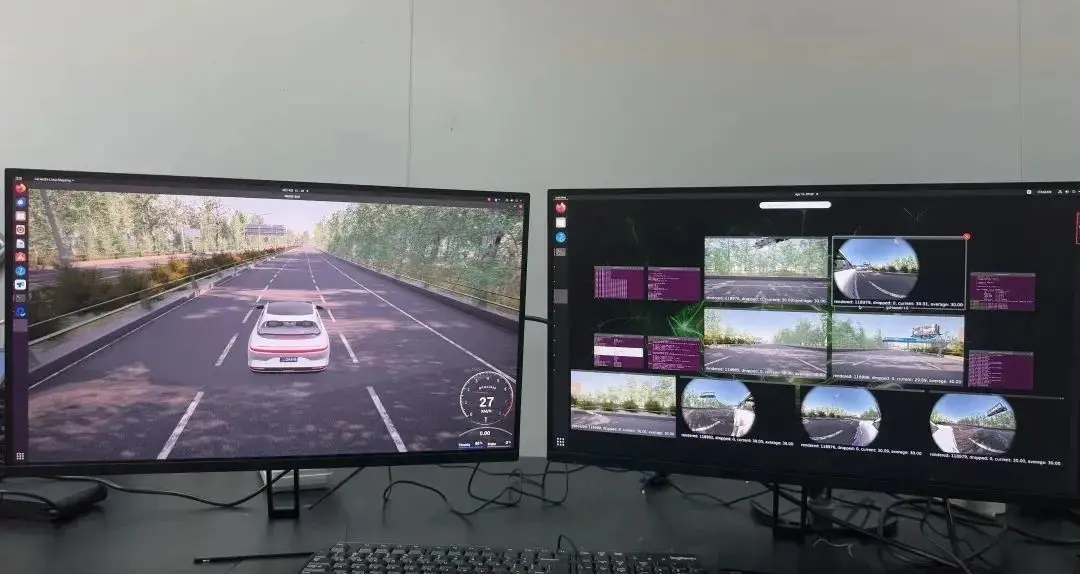

系统以OASIS SIM为中枢引擎,联动Unreal Engine 5.5构建的毫米级逼真场景库与Carla仿真引擎的定制化开发接口,通过主从机分布式架构实现算力动态调度:主机(Master)集中管理多类型传感器协议转换与任务分发,从机(Slave)集群基于显卡并行计算完成视频流(4K@30fps/2K@60fps)、激光雷达(128线束级点云)、毫米波雷达等数据的实时渲染,最终通过视频注入板卡将HDMI/GMSL信号注入域控制器,同步支持以太网/CAN总线协议闭环反馈,形成感知层-决策层的端到端仿真验证。

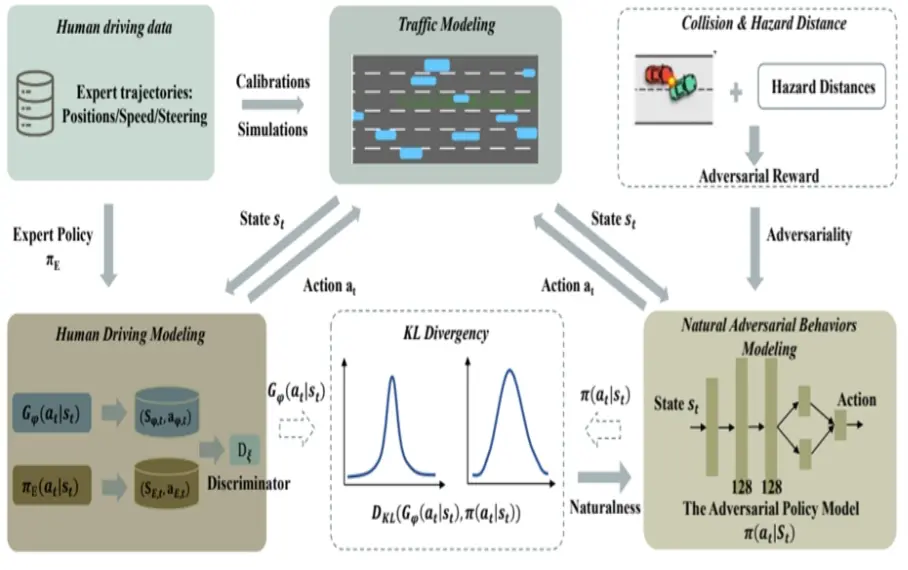

- 基于路采数据训练获得与人类驾驶习惯相近的AI自然驾驶模型,保证测试场景中的NPC车辆的真实性。

AI交通流示例

1. 实现高精度场景建模与仿真- 基于厘米级精度路网建模引擎,构建包含车道线曲率、坡度、交通标志/标牌语义信息的多维度路网拓扑,支持直道、连续弯道、十字路口(含无保护左转)、环岛及立体匝道等复杂场景的精细化还原,路网要素几何误差<0.1%,满足ISO 26262场景覆盖度要求。

1. 实现高精度场景建模与仿真- 基于厘米级精度路网建模引擎,构建包含车道线曲率、坡度、交通标志/标牌语义信息的多维度路网拓扑,支持直道、连续弯道、十字路口(含无保护左转)、环岛及立体匝道等复杂场景的精细化还原,路网要素几何误差<0.1%,满足ISO 26262场景覆盖度要求。 2. 提供动态场景编辑能力- 引入便捷的动态场景编辑工具,允许用户动态添加或调整机动车、非机动车、行人等交通参与者的行为与轨迹,支持丰富的交通场景模拟,满足复杂动态环境下的智能驾驶系统测试需求。

2. 提供动态场景编辑能力- 引入便捷的动态场景编辑工具,允许用户动态添加或调整机动车、非机动车、行人等交通参与者的行为与轨迹,支持丰富的交通场景模拟,满足复杂动态环境下的智能驾驶系统测试需求。 3. 构建多维环境模拟系统- 依托UE5 Lumen动态全局光照与Nanite虚拟几何体技术,支持多种自然天气(如雨、雪、雾、沙尘等)和不同光照条件(如白天、夜晚及复杂光源)的模拟,为车辆感知系统测试提供真实感强的环境输入。

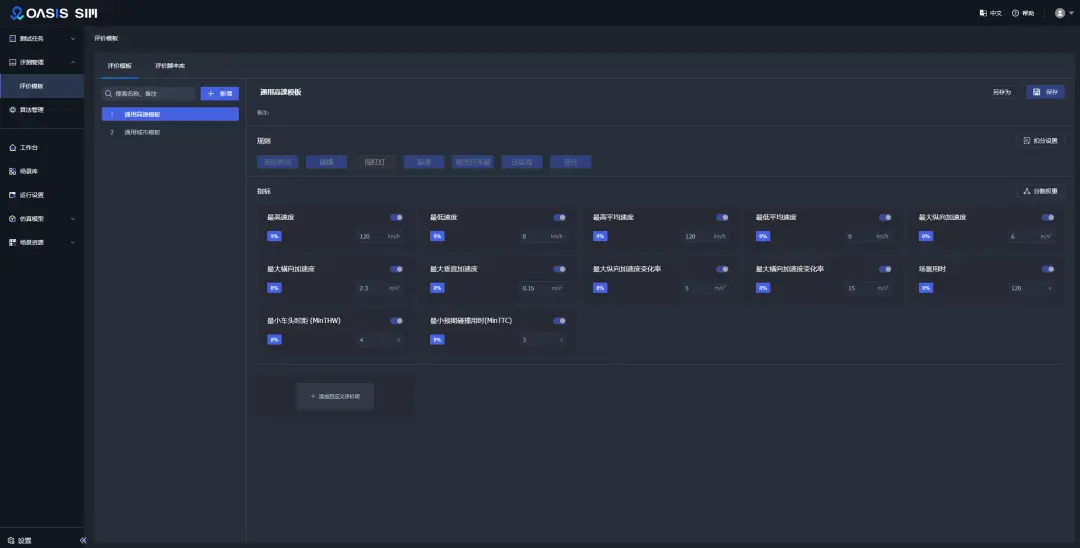

3. 构建多维环境模拟系统- 依托UE5 Lumen动态全局光照与Nanite虚拟几何体技术,支持多种自然天气(如雨、雪、雾、沙尘等)和不同光照条件(如白天、夜晚及复杂光源)的模拟,为车辆感知系统测试提供真实感强的环境输入。 3. 支持测试用例管理- 搭建完善的测试用例管理系统,支持测试用例的创建、组织、执行与结果分析。可自定义评测指标、添加评测脚本。

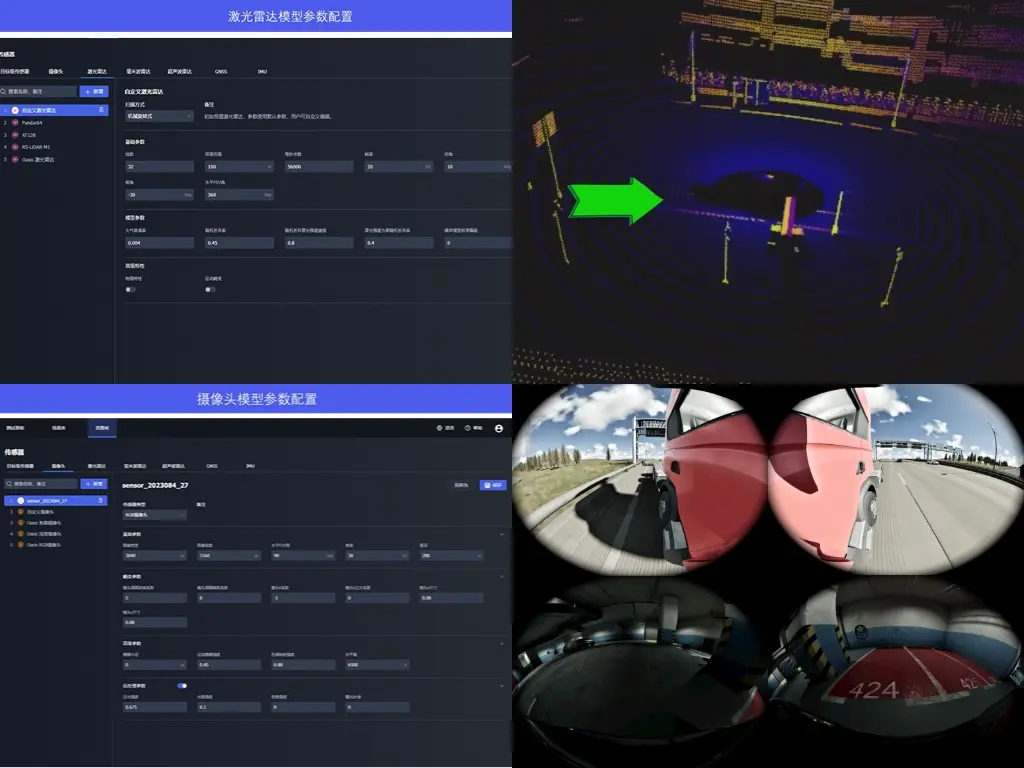

3. 支持测试用例管理- 搭建完善的测试用例管理系统,支持测试用例的创建、组织、执行与结果分析。可自定义评测指标、添加评测脚本。 5. 多种车载传感器仿真- 支持摄像头、激光雷达、毫米波雷达、超声波传感器等多类型传感器仿真,并输出高质量的仿真数据,为智能驾驶感知、决策与控制算法的研发提供精准的数据支持。

5. 多种车载传感器仿真- 支持摄像头、激光雷达、毫米波雷达、超声波传感器等多类型传感器仿真,并输出高质量的仿真数据,为智能驾驶感知、决策与控制算法的研发提供精准的数据支持。 6. 真实交通流与AI对抗模型- 构建真实世界的交通流仿真环境,模拟车辆与行人的自然行为干扰。支持AI对抗模型,符合人类激进驾驶的风格和智能性。AI对抗可持续交互,可自定义交互的范围与时间,最大交互时间大于10s。AI对抗交通流与真实交通流(NGSIM)对比,TTC分布在(2s,100s]区间内概率分布平均误差小于0.1%(以1s为刻度),在[0s,2s]区间概率增加5%以上。

6. 真实交通流与AI对抗模型- 构建真实世界的交通流仿真环境,模拟车辆与行人的自然行为干扰。支持AI对抗模型,符合人类激进驾驶的风格和智能性。AI对抗可持续交互,可自定义交互的范围与时间,最大交互时间大于10s。AI对抗交通流与真实交通流(NGSIM)对比,TTC分布在(2s,100s]区间内概率分布平均误差小于0.1%(以1s为刻度),在[0s,2s]区间概率增加5%以上。

|

|

|

|

来源:深信科创