自动驾驶中雷达与相机融合的目标检测工作多模态目标检测:

-

在之前,我已经有介绍过毫米波雷达在2D视觉任务上的一些经典网络:总结概括而言,其本质上都是对视觉任务的一种提升和辅助,主要的工作在于如何较好地在FOV视角中融合两种模态,其中不乏有concate\add\product两个模态的特征,或者使用radar对视觉局部特征增强,其中比较知名的工作CRFNet经常用来作为baseline,其并没有对毫米波这个模态做特殊的处理,仅是作为视觉特征的补充融入到传统的2D检测pipeline中,但是其消融实验提出了许多值的考虑的优化方向:包括噪声滤除、BlackIn这两个,一个代表了对于毫米波这类有较多噪声的数据进行“理想化”的噪声过滤,结果提升了接近10个点。二是通过BlackIn对于弱模态-毫米波点云加大学习权重(通过对训练时图像的缺失)来提高网络对于高噪声弱模态的拟合能力也能提点。

-

在近些年,2D检测任务在自动驾驶的热度递减,取而代之的是3D任务,毕竟现在的实际场景一直多是基于3D场景。但是在3D检测或者分割等任务中,雷达赋予了一个不一样的角色,在之前FOV视角中,毫米波点云大多为了与FOV特征融合,都是通过投影这一种方法,而放到3D场景中,分为两个流派:一个是点云流派:由于lidar和radar具有天然的相似性(当然是处理后的点云),自然就有lidar的相关角色赋予毫米波雷达,相应的,毫米波的角色从FOV到了BEV,它的下游任务,也从辅助为主到BEV下的分割、深度估计、生成密集点云等。另一个Range-Doppler流派:投入到毫米波雷达原始数据中去探求毫米波特有的处理方式,并且取得了不错的成果。

-

这也是我这篇文章的重点,文章的主要工作放在毫米波角色的转换中,从3D检测、深度估计、GAN(非重点),分割(非重点)几个方面列举我看到的一些工作并做简单介绍和总结,同时对毫米波算法的发展提出自己的一些拙见,毫米波雷达相关领域深邃奥妙,仅通过几篇文章认识它无疑是管中窥豹,由于个人能力有限,所以后面还会继续以各个子章节细化,组成系列文章。

介绍的工作都比较冷门,很少有源码开放,因此对一些细节分析可能并不到位,欢迎大家在评论区讨论,提出自己的宝贵意见,指正我的一些偏见。

一、3D Detection

1.1 GCN:图卷积用于毫米波目标检测

1.1.1 GCN用于毫米波点云

-

Radar-PointGNN: Graph based Object Recognition for Unstructured Radar Point-cloud Data(**2021 IEEE Radar Conference)**之前我发过一篇文章:用于毫米波雷达的GNN—https://zhuanlan.zhihu.com/p/549641548

1.1.2 GCN用于原始毫米波信号

-

Graph Convolutional Networks for 3D Object Detection on Radar Data (2021 ICCVW)建议在阅读这篇工作前,先阅读一篇关于雷达数据处理的文章以了解RD和RadarPointCloud的区别:毫米波雷达:信号处理—https://zhuanlan.zhihu.com/p/524371087

-

Abstract:作者借鉴GCN,提出基于毫米波原始数据Range-beam-Doppler tensor进行3D目标检测GRT-Net,相比作者自设定的baseline(grid-based-convolutional baseline也就是voxel这类方法)提升约10%,同时作者在真实环境下自采的数据集合来验证模型效果。此外,将检测距离增加至100m,大幅度提升检测范围。

-

网络结构:

这项工作的输入数据,并不是常见的雷达点云形式,这类点云是经过CFAR等算法处理后的结果,这类算法处理后的结果会导致原始信息丢失的问题(部分工作将CFAR更换为DL模型后能够有效降低点云噪声),近期的一些工作例如CRUW数据集,提供点云的上层数据-Range-Doppler数据,这类数据能够以较小损失的条件下保留较多的原始信息,但是,相对点云原始数据无法直接将数据用于检测等现有任务并且数据的直观性和结构化降低。在GCN中,RD不能够直接用于构建Graph,作者将其处理为range-beam-doppler坐标系下的voxel用于构建节点,edge则采用两种方案:根据节点的距离确定和固定权重。

-

重要部分:

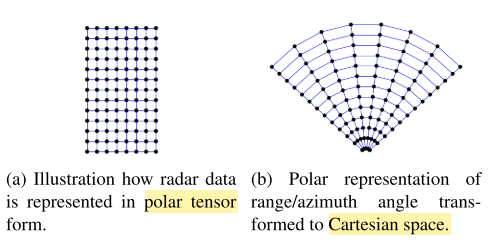

(1) 极坐标系和笛卡尔坐标系

这里简单聊一下毫米波数据的转换过程,如上图所示,从左到右经过三次FFT变换,从原始的传感器采集到的MNK维度的IF信号到最后的RD数据,就是我们所需要的原始雷达数据,对RD数据进一步处理,得到点云数据信息,我们需要的是上图中最后一个数据的形式。(2) 图的构建

-

边的定义

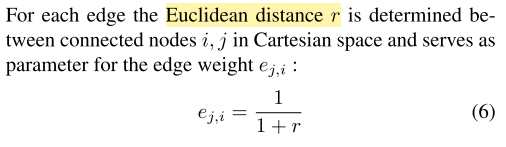

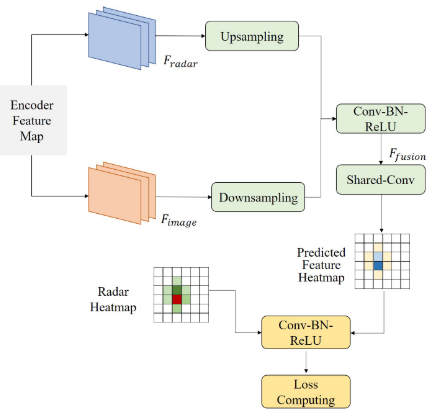

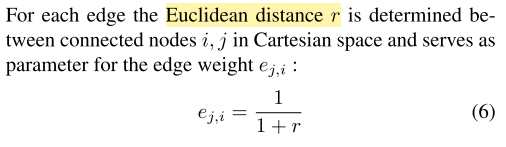

首先,Radar-Doppler-Tensor作为输入数据(HWC),然后将输入切分成range-beam为单位的cell作为基本单元,每个cell(256 channels doppler)作为node feature,这样就完成了节点的原始特征定义。对于edge的定义如下(图的边则连接相邻range或者相邻angle的节点,边的权重与欧式空间中节点距离成反比(实验证明这个权重的设置并不重要):

-

点的定义

GCN包括两层的图卷积(Aggregate Spatial Information, ReLU),此时向量变为channel=3的Tensor,然后经过双线形插值将数据转换为笛卡尔坐标系方便目标检测,后送入到FPN中融合多尺度的Range-Doppler数据,最后通过two-stage方法,将RoI-Proposal的向量提取并通过两个FC进行类别和属性的判别并通过NMS进行处理。以下是原始的Radar beam Tensor和经过转换到笛卡尔坐标系后的Tensor。

-

节点更新:和GCN保持一致

-

实验:

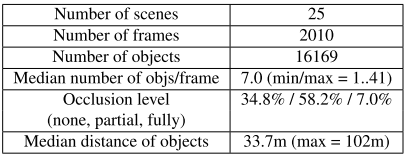

如下,作者采集自真实场景的数据集各项参数:可以看出,部分遮挡的目标占有大半部分,目标大都分布在33.7m左右

如下,数据集中对于目标检测难度的定义:从距离和遮挡程度两者考虑

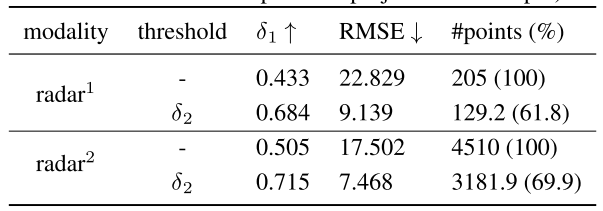

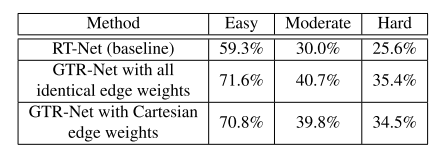

baseline(GRT-Net):作者仅是为了证明voxel-based方法和graph-based方法的优劣性,将上述的两层图卷积网络替换为普通的2D卷积,激活函数等其他网络设置相同,具体结果如下所示:

来源:自动驾驶之心